Una escuela alemana. Los orígenes de la Escuela de Filosofía de la UCV

Luz Marina Barreto (Caracas, 1960) escribe sobre el contexto teórico-filosófico del que surgió la Escuela de Filosofía de la Universidad Central de Venezuela, algunos de sus primeros exponentes y las ideas que guiaron hacia mediados del siglo pasado sus primeros pasos. “A mediados del siglo XX, la filosofía alemana parecía definir realmente ese hito y ese horizonte al que había que aspirar. Y no simplemente la filosofía a secas, sino la ontología y, en particular, la ontología fenomenológica, aquel proyecto cuya urgencia había comprendido Franz Brentano en 1862.”

„Im normalen Leben wird einem oft gar nicht bewußt, daß der Mensch überhaupt unendlich mehr viel mehr empfängt, als er gibt, und daß Dankbarkeit das Leben erst reich macht. Man überschätzt wohl leicht das eigene Wirken und Tun in seiner Wichtigkeit gegenüber dem, was man nur durch andere geworden ist.“

Dietrich Bonhoeffer

“Normalmente, a menudo uno ni siquiera se da cuenta de que una persona recibe infinitamente más de lo que da, y de que la gratitud enriquece la vida. Es fácil sobreestimar la importancia del propio trabajo y actividad en comparación con lo que uno sólo pudo haber sido gracias a otros.»

Dietrich Bonhoeffer

“Brief an Karl und Paula Bonhoeffer”, 13 de septiembre de 1943 y Widerstand und Ergebung

En el año 1900, en un Congreso científico en la ciudad de París, el matemático David Hilbert presentó ante sus colegas una lista de los desafíos de la ciencia que él esperaba podían o debían ser resueltos durante el siglo 20. Este siglo, que se iniciaba con gran optimismo entre los sectores científicos, parecía vislumbrar la conclusión de los problemas aún abiertos en la física teórica de la época, que ya parecía ofrecer un compendio definitivo de conocimientos acerca de la realidad, así como iba a servir de modelo a todas las demás ciencias exactas.

La aspiración general de estos sectores académicos era la de poder extender el éxito de la mecánica clásica a todos los otros ámbitos de conocimiento científico. La mecánica de Newton se erigía, en aquel momento, como el modelo por excelencia de conocimiento bien fundamentado, preciso, porque describía en términos analíticos, en un espacio geométrico, la trayectoria de cualquier objeto en movimiento, logrando con ello también poder predecir la ubicación de ese objeto en algún punto en el futuro. Que esta predicción se pudiera hacer en términos analíticos significaba que se contaba con herramientas matemáticas para definir una función capaz de describir la tasa de cambio de la velocidad de un objeto en el espacio, entendido éste como un espacio geométrico imbuido en un sistema de coordenadas.

Este espacio de coordenadas era también un modelo ideal de nuestro espacio intuitivo de tres dimensiones. El hecho de que se pudieran modelar nuestras intuiciones cotidianas, respecto del movimiento de objetos físicos reales, para poder predecir su ubicación en algún punto en el futuro constituyó una hazaña teórica sin precedentes en la historia.

Pero ¿por qué querría la física poder representar nuestras intuiciones respecto de nuestro espacio cotidiano de tres dimensiones con un modelo analítico? La respuesta la había sugerido Aristóteles más de 2000 años antes, en un tratado titulado por sus compiladores y comentaristas los Analíticos Posteriores. Aristóteles había postulado allí que una ciencia exacta debía estar sólidamente asentada sobre un sistema coherente de intuiciones auto-evidentes o, como él los llamó, “axiomas”. Junto con él, toda la filosofía del siglo XX pensaba todavía que una proposición o enunciado respecto del mundo objetivo sería verdadero en la medida en que reflejaba de modo adecuado el ámbito de la realidad al que hacía referencia. Pero, para que eso sucediera, Aristóteles creía que al menos un grupo de proposiciones debían ser enunciados de fundamentación, es decir, estar “más cerca de lo real” que otros. Estos enunciados fundamentales tendrían un carácter axiomático en la medida en que referían verdades auto-evidentes, es decir, que no requerirían de otras explicaciones ulteriores para ser considerados verdaderos por un grupo de hablantes enfrascado en un intercambio racional o dialéctico de argumentos.

La búsqueda de estos axiomas o intuiciones auto-evidentes era para Aristóteles la tarea de una ciencia que quisiera levantarse sobre cimientos sólidos, dado que a partir de ellos era posible concebir que dos interlocutores pudieran ponerse de acuerdo sobre algo: primero se daría un acuerdo sobre axiomas, que como son auto-evidentes se supone que no son polémicos, y a partir de allí se construirían teoremas y reglas de inferencia. Euclides desarrolla sus Elementos de Geometría siguiendo esta idea y los sustenta sobre un sistema con cinco axiomas, tales como que siempre se puede trazar una línea recta entre dos puntos, o una línea recta puede ser prolongada infinitamente en cualquier dirección, etc.

Hoy en día, sabemos ya que estos axiomas no son para nada intuiciones auto-evidentes. Por ejemplo, se cree que el quinto axioma, el de las paralelas, está allí simplemente para ofrecer un fundamento intuitivo al teorema de Pitágoras, el que afirma que la suma del cuadrado de los catetos es igual a la suma del cuadrado de la hipotenusa, porque este era importante en la antigüedad para calcular la altura de objetos y otras distancias útiles, como la de un terreno que alguien quisiera vender. Así y todo, la idea de que la geometría euclidiana se apoyaba en un sistema axiomático coherente era el fundamento filosófico que explicaba y justificaba a los ojos de los científicos modernos el éxito de la geometría analítica y la mecánica clásica de Newton. Dicho en otras palabras: las herramientas de la geometría analítica y su uso en la mecánica clásica producen conocimientos verdaderos porque se suponía estaban firmemente asentadas sobre el suelo de un sistema axiomático coherente: el de la geometría euclidiana, la geometría de nuestro espacio intuitivo de tres dimensiones.

Para la filosofía del cambio del siglo, la validez de la mecánica clásica, ese modelo de conocimiento científico que sería seguro por excelencia, era subsidiaria de un sistema de intuiciones básicas que define en términos analíticos y racionales nuestro espacio geométrico intuitivo de tres dimensiones. Así, cuando David Hilbert presenta ante el Congreso de Matemática de París en 1900 su listado de desafíos teóricos que deberían ser resueltos en el siglo que se iniciaba, incluye en él la importancia de definir también un sistema coherente y completo de axiomas que ofrezcan un fundamento sólido para todas las ciencias que quedan por desarrollarse según el modelo de la mecánica clásica, es decir, ofreciendo al marco teórico geométrico-analítico un sistema axiomático que completará la sintaxis lógica del discurso racional.

Sin embargo, el proyecto de Hilbert se planteaba en el medio de desarrollos en la física (la teoría termodinámica y la electrodinámica), y en la biología, la química y la fisiología, que desafiaban la pretensión de que la mecánica clásica ofrecería un único modelo del conocimiento verdadero de validez universal (Moulines, 2011, p. 20). Una pretensión de este tipo animaba, en parte, el proyecto kantiano de fundamentación trascendental del conocimiento, en donde un espacio y tiempo de carácter trascendental posibilitaban la comprensión racional de las ecuaciones de la física, entendida conforme al modelo de la mecánica clásica. El filósofo alemán de origen judío, Hermann Cohen, quien ostentó una cátedra de filosofía en Marburgo hasta 1912, consideraba, en efecto, el proyecto kantiano de la Crítica de la Razón Pura (1781) como la fundamentación filosófica que explicaba el éxito de la mecánica clásica (Scott, 2020), que no sería sino la extensión de las capacidades humanas para comprender la realidad, o dar cuenta de ella, en la forma de conocimientos “sintéticos a priori”.

Los desarrollos de las disciplinas ya mencionadas comenzaron a poner en duda que la mecánica clásica constituyera el único modelo posible de conocimiento verdadero respecto de la realidad. De hecho, como lo mostrará Albert Einstein en 1905, el espacio y tiempo absolutos, proyectados si se quiere por el sujeto de conocimiento, no permiten una representación de las funciones que describen el movimiento de objetos en todo sistema posible de coordenadas y, por lo tanto, resultan insuficientes para una descripción adecuada de lo que sucedía en realidad en el mundo objetivo cuando se trasladaban objetos en el espacio en distintos marcos de referencia, en particular la luz, cuya velocidad es constante (Einstein, 1916). Muy importante para Einstein en el desarrollo de estas intuiciones es el programa previsto por Ernst Mach para la fundamentación del conocimiento.

A diferencia de Kant, el físico y filósofo austriaco Ernst Mach piensa que una fundamentación transcendental de la mecánica clásica necesita ser sustituida por una fenomenología, un análisis fenoménico-sensorial de nuestras intuiciones elementales basado en una fisiología. Como tal, el proyecto se distingue del de Hilbert en el sentido de que no se trata de encontrar un sistema de intuiciones auto-evidentes o axiomas para fundamentar las ciencias, sino de definir las sensaciones orgánicas básicas a partir de las cuales pudiéramos decir que los conocimientos científicos se encuentran verdaderamente anclados a una realidad común que compartimos como individuos racionales. Seguidamente, desde allí había que encontrar expresiones que refirieran a estados de cosas básicos, o, dicho de otro modo, enunciados observacionales de índole primordial (un ejemplo clásico sería “la pelota es roja”). Pero la idea de Mach no era construir con ellos una lógica cuya sintaxis, teoremas y reglas de inferencia, garantizaría la racionalidad de las teorías científicas, como era el proyecto de Hilbert, sino mostrar por qué creemos que un enunciado es verdadero y hacerlo con base en lo que la humanidad puede percibir en común del mundo que la rodea.

El programa de Mach fue muy importante para cimentar los primeros desarrollos de la filosofía de la ciencia del siglo XX. Influyó de manera decisiva en las teorías de la verdad científica de filósofos como Ludwig Wittgenstein y el Círculo de Viena, pero también de Albert Einstein, cuyas teorías de la relatividad especial y general (que es la síntesis contemporánea de la mecánica clásica), tienen como horizonte último de su validez un criterio de tipo machiano, a saber, que la causalidad debe propagarse a la velocidad de la luz, dado que en la teoría de la relatividad el tiempo se convierte en un parámetro o una dimensión efectiva de todo marco de referencia. Esto permite interpretar, como lo hicieron muchos epistemólogos o filósofos de la ciencia en su época, a la teoría de la relatividad, en el fondo, como una teoría que postula la velocidad de la luz como el límite superior de la propagación de causas en el espacio-tiempo. Einstein pensaba que ninguna teoría física podía violar el principio de causalidad por el cual las causas anteceden a los efectos y el uso que él hace del criterio de la propagación de la luz en el vacío para definir un principio de relatividad evidencia su apego a los criterios esbozados por Ernst Mach para demarcar una teoría científica verdadera de una falsa, en tanto y en cuanto el principio de causalidad constituye una intuición básica inviolable (Lestienne, 1995).

Pudiéramos entonces decir que, en el cambio al siglo XX, en términos generales dos proyectos de fundamentación del conocimiento científico se encuentran en tensión: por un lado, está el proyecto esbozado por Hilbert, que es, en el fondo, el mismo de Aristóteles, y un proyecto fenomenológico, cuyos alcances desbordan la lógica y es mucho más ambicioso: el de desarrollar una disciplina tan básica como la matemática o la lógica que ofrezca un cuerpo completo y coherente de proposiciones ordenadas en un sistema que reconstruya una concepción común de lo que sea la realidad para los seres humanos en general.

Sin embargo, también es posible constatar que el proyecto de Mach se desliza peligrosamente hacia la constitución de una disciplina científica de carácter teórico, parecida a la psicología o a la fisiología, entendida ahora como disciplina de fundamentación del conocimiento en general, alejándose así de la lógica. Pero el desarrollo de una tal disciplina habría sido un error. Una teoría de los modos como el ser humano percibe fisiológicamente lo real no puede convertirse en una fundamentación epistemológica del conocimiento verdadero porque dicha teoría requiere, a su vez, criterios de fundamentación que permitan clasificar algunas intuiciones como más básicas o comunes que otras y, por lo tanto, algún criterio externo que defina la validez de sus enunciados de base.

Pese a ello, la idea de que el alud de conocimientos científicos que inunda las dos primeras décadas del siglo, con la teoría de la relatividad especial y general en el centro de una revolución teórica totalmente inesperada, requiere el desarrollo de una disciplina de fundamentación que ofrezca pilares sólidos a los conocimientos teóricos, comienza a presionar los intereses y derroteros de las investigaciones de las cátedras de filosofía de Europa, especialmente en Inglaterra y en Alemania. Mientras que en el primer país se trabajaba activamente en la dirección propuesta por Hilbert (por ejemplo, con la redacción del Principia Mathematica de Bertrand Russell y Alfred North Whitehead), en Alemania el lógico Gottlob Frege también buscaba una fundamentación lógica de la ciencia, pero con un énfasis en la filosofía del lenguaje y en la búsqueda también de los fundamentos del lenguaje natural, el cual, después de todo, son lo que permiten que podamos entendernos sobre algo en el lenguaje ordinario.

Alrededor de propuestas como las de Frege se comienza a aglutinar también una serie de filósofos que bien pudieran haber clasificado el programa de Mach como “psicologista”, es decir, un retroceso respecto de la propuesta de Kant y el neo-kantianismo de Cohen. Estaba claro para ellos que una propuesta como la del empirio-criticismo de Mach, con su sistema de impresiones sensoriales básicas establecido por una fisiología, produciría una filosofía de la ciencia encerrada en el sujeto y, por lo tanto, totalmente relativa a las condiciones subjetivas de la especie humana. Este temor es el reproche de psicologismo: la subordinación de la verdad a las condiciones psicológicas (o en el caso de Mach, fisiológicas) del sujeto de conocimiento.

Pero, por otro lado, el temor del relativismo, de no encontrar esa fundamentación sólida de las ciencias como la que aspiraba Aristóteles en su tratado de los Analíticos Posteriores, se asoma también por el lado de los lógicos. Hilbert mismo, en su Grundlagen der Geometrie, estaba trabajando ya sobre la fundamentación de geometrías no euclidianas que se habían estado desarrollando desde mediados del siglo 19 de la mano de matemáticos de la talla de Carl Gustav Gauss, por ejemplo. Estas geometrías, como señala el filósofo español Jesús Mosterín, representaban un problema para la epistemología porque contradicen las intuiciones que dependen de nuestro espacio cotidiano de tres dimensiones (Mosterín, 2000). Al mismo tiempo, otro libro de Aristóteles, la Metafísica, influía en la ya mencionada corriente de la filosofía alemana que, en consonancia con la interpretación kantiana de la metafísica, consideraba que la fundamentación del conocimiento no era una tarea meramente para la lógica formal, sino que requería comprender cómo nos entendemos respecto del mundo con el lenguaje natural.

El retorno de la ontología

Así pues, con el cambio al siglo XX, dos interpretaciones diferentes de aquello que posibilita que podamos formular conocimientos comienzan a verse confrontadas. Ambas interpretaciones hunden sus raíces en Aristóteles. La primera se apoya en el programa axiomático expuesto en los Analíticos Posteriores. La segunda es defendida por Immanuel Kant y se apoya en el libro primero de la Metafísica de Aristóteles, también conocido como “la primera parte de la metafísica”. La idea de Aristóteles aquí es que, como paso previo al desarrollo de cualquier ciencia, es necesario comprender cuáles son “nuestros modos de decir el ser”, es decir, cómo es que podemos clasificar algo como algo. O cómo podemos decir que algo es algo y entendernos cuando nos referimos al mundo. En otras palabras: una cosa es que yo pueda decir “esto es una mesa”, y otra distinta es que sea capaz de referirme a objetos en el mundo en general, sean estos mesas, lámparas o libros. La pregunta aquí apunta a algo más básico que definir objetos singulares: se refiere a cómo es posible para un ser humano denotar un objeto como objeto de la atención o conciencia humana, o, para decirlo en el lenguaje técnico de la filosofía: como objeto intencional. O para decirlo como Kant: apunta a nuestra capacidad para referirnos a cualquier objeto de la experiencia, lo que el filósofo de Königsberg llamaba el “objeto trascendental”.

La filosofía del cambio de siglo XIX al XX en Europa comenzó a ver cada vez más con mayor claridad que no podrían darse desarrollos científicos de ningún tipo si no éramos capaces de comprender cómo el ser humano puede, no ya construir una ciencia cualquiera, sino ponerse de acuerdo con otros respecto de la realidad elemental de todos los días. Como hemos visto, los bandos estaban divididos por zonas geográficas: la filosofía anglosajona, en especial la inglesa, estaba preocupada por la posibilidad de ofrecer un sistema axiomático de carácter lógico completo y coherente para las ciencias, en particular para la matemática y la física teórica, conforme al proyecto aristotélico del tratado de los Analíticos Posteriores, mientras que la filosofía “continental”, como se la llamaba en la época, en particular la filosofía alemana, estaba preocupada con la idea de una fundamentación filosófica de las fuentes del conocimiento verdadero en el lenguaje ordinario o natural, dado que se daba cuenta de que el compendio del conocimiento verdadero no podía quedar limitado a la mecánica clásica a la luz de los avances notables de otras disciplinas científicas de carácter teórico, como la biología, la química y la electrodinámica, para no hablar de lo que sucedía en las ciencias sociales, o, como las llamaba Dilthey, “ciencias del espíritu”. El legado de Kant a la filosofía alemana había sido que el conocimiento racional podía extenderse hacia otras formas de entenderlo: a la moral, la ética, la historia y lo que hoy llamamos las ciencias humanas.

El alcance de este extrañamiento de propósitos y entendimientos entre la ciencia y la filosofía no se puede comprender si no recordamos, además, que estamos hablando de un continente en el cual no existía la fluida comunicación entre regiones que hay ahora. No se viajaba tanto, la correspondencia epistolar tardaba meses en llegar. Inglaterra y el “continente”, en particular Alemania, que era una potencia filosófica y científica, no se comunicaban entre sí y, con el estallido de la Primera Guerra Mundial, el cisma y la desconfianza mutua se profundizaron todavía más. Como parece evidenciarlo la película de género biográfico Einstein and Eddington, de 2008, escrita por Peter Moffatt, la idea de que la mecánica clásica, y su tratamiento analítico de los objetos, era la única forma posible de concebir el conocimiento verdadero se convirtió para los ingleses en un asunto de honor y de orgullo nacional.

Cuando en 1905 Albert Einstein publica cinco artículos revolucionarios, entre los cuales se encontraba “Sobre la electrodinámica de los cuerpos en movimiento” (su teoría de la relatividad especial), la visión de que la mecánica clásica representa el culmen de la física teórica ya comenzaba a tambalearse. En la misma medida, el problema clásico de la Metafísica de Aristóteles, que se interroga sobre nuestros modos más fundamentales de aprehender la realidad y referirnos a ella, comienza a influir entre los filósofos de la época.

En mi opinión, lo que está haciendo crisis realmente es la confianza en la interpretación que hace Kant de la mecánica clásica, que, de acuerdo con él, pudiera ofrecer un método a la metafísica primera para ayudarla a tomar “el camino seguro de la ciencia”. Kant pensaba que la mecánica clásica, como teoría que da cuenta y analiza en un plano geométrico el movimiento de los objetos en la experiencia, refleja, si se quiere, una suerte de esquematismo básico que expresaría nuestros modos elementales de aprehensión de todo objeto en nuestro entendimiento.

Pero el cálculo diferencial de Newton, que rastrea la tasa de cambio de un objeto cualquiera en el sistema de coordenadas que representan las dimensiones absolutas del espacio y del tiempo, sólo puede hacerlo al precio de la abstracción algebraica, y esto es lo que, en definitiva, le permite a Kant definir cualquier objeto con el mismo grado de abstracción, en tanto que objeto “trascendental”. A este respecto, es ilustrativo lo que escribe Bertrand Russell sobre este tipo de reducción de dimensiones:

“No siempre se comprende cuán sumamente abstracta es la información que la física teórica tiene que dar. Establece ciertas ecuaciones fundamentales que le permiten lidiar con la estructura lógica de los eventos, dejando completamente desconocido cuál es el carácter intrínseco de los eventos que tiene esa estructura … Todo lo que nos da la física son ciertas ecuaciones que dan propiedades abstractas de sus cambios. Pero en cuanto a qué es lo que cambia, y desde qué y hacia qué cambia, en cuanto a esto, la física no dice nada” (Bertrand Russell, My Philosophical Development, London, Unwin Paperbacks, 1985, p.13. Citado por Edward Feser) (Feser, 2017).

Pienso que el proyecto de la fundamentación axiomática y lógico-matemática del conocimiento confiaba especialmente en la visión que el neo-kantianismo, especialmente el de Cohen, tenía de la mecánica clásica como expresión privilegiada de las capacidades humanas para relacionarse con la realidad a través de un marco conceptual racional. Esta visión inevitablemente privilegia la lógica matemática como el instrumento cuyo sistema axiomático completo debía descubrirse en el transcurso del siglo, como lo había sugerido Hilbert en el Congreso de París en 1900.

Pero lo que terminó sucediendo fue que el surgimiento de nuevas disciplinas científicas volvieron obsoleta a la filosofía trascendental kantiana como paradigma de una ontología exhaustiva. La frase de Russell que acabamos de citar, habiendo sido él mismo uno de los protagonistas del proyecto esbozado por Hilbert que buscaba encontrar un fundamento axiomático completo y consistente para la lógica matemática, es reveladora: la fundamentación del conocimiento, entendida como la propone Aristóteles en su tratado de los Analíticos Posteriores, no podía continuar.

A ello se le agrega el golpe que le da Einstein a la mecánica clásica newtoniana. Albert Einstein, muy influenciado por la filosofía de Ernst Mach, revela en su artículo de 1905 sobre la relatividad general las inconsistencias de la mecánica clásica y la electrodinámica para dar cuenta analíticamente del comportamiento de la luz. Al mostrar sus ecuaciones de 1915 que, en la dimensión del espacio-tiempo, cualquier objeto que se aproxime a la velocidad de la luz se “ralentiza”, incapaz de superarla, lo que afirma es que la información de los efectos de un evento no puede alcanzarnos antes que la información sobre las causas que lo producen, dado que la relatividad general preserva la simetría y consistencia de la flecha del tiempo en todo el universo (Einstein, 1916). El hecho de que, para Einstein, sus ecuaciones demuestren que no es posible desestimar nuestro concepto intuitivo cotidiano de que todo efecto debe estar precedido por una causa, es revelador de su necesidad de satisfacer uno de los presupuestos de la filosofía de la ciencia de Ernst Mach: el que los fundamentos últimos del conocimiento científico estuvieran firmemente asentados en nuestra experiencia intuitiva básica (y no simplemente en sistemas de axiomas lógicamente consistentes).

A los artículos de Einstein y a los desarrollos de otras teorías científicas distintas de la física teórica, se agregan ahora también otras innovaciones de índole socio-cultural. En efecto, como ha señalado Ferdinand Fellmann, en su libro Fenomenología y expresionismo, las dos primera décadas del siglo XX son tumultuosas, caracterizadas por la disrupción, en un orden mundial estable y carente de novedades, de desarrollos políticos y económicos imprevistos, un mundo que de pronto da lugar a la Primera Guerra Mundial, a la debacle del modelo neoclásico de la economía y, además, a las ya mencionadas revoluciones en las ciencias, especialmente la que provoca la teoría de la relatividad general. De acuerdo con Fellmann, la ruptura con un mundo cuya estabilidad parecía inconmovible, abre el camino a un pensamiento filosófico interesado en la pregunta de cuál sea la “realidad verdadera” en un entorno epocal que ya no se percibe como tan seguro. Se trata a la vez de un pensamiento filosófico que se abre paso en las facultades de filosofía de Europa y Estados Unidos, como reflexión seria y profesional, como de uno que extiende también su influencia en los cafés de Viena, en la cultura, en las artes y en las ciencias de su época, en la música de Igor Stravinsky y Arnold Schoenberg, en el arte del expresionismo alemán, en las teorías de Sigmund Freud y John Maynard Keynes (Fellmann, 1984). Ya en 1862, el psicólogo y fenomenólogo Franz Brentano había escrito un libro que hubo de tener una influencia importantísima en el renacimiento del interés por la ontología clásica a inicios del siglo XX: “Sobre los múltiples significados del ser en Aristóteles” (Von der mannigfachen Bedeutung des Seienden nach Aristoteles). Esta vez se insistía, como lo hizo también Kant unos siglos atrás, que había que volver al Libro Primero de la Metafísica de Aristóteles, es decir, en la necesidad de comprender cómo es posible clasificar algo como algo, aprehender un objeto cualquiera en el marco de la realidad circundante, para poder ponernos de acuerdo sobre algo.

El pensamiento de Brentano, quien escribió sucesivamente varios libros dedicados a la necesidad de retornar al realismo aristotélico, influyó enormemente en el desarrollo de la nueva ontología del siglo XX que eclosionó en Alemania. Ella abre una corriente alternativa al “logicismo” anglosajón del cambio de siglo, como lo llamaría Etienne Gilson, desplazándolo casi completamente y dominando el pensamiento filosófico durante casi toda la primera mitad del siglo XX.

Husserl y Heidegger

En Alemania, la figura central y el verdadero impulsor de este movimiento filosófico renovador de la ontología clásica fue Edmund Husserl. El libro Ontología del siglo XX (1997), del filósofo venezolano de origen catalán, y profesor de la Escuela de filosofía de la Universidad Central de Venezuela desde 1955 hasta su jubilación en 1980, Federico Riu, contiene, en mi opinión, una de las mejores y más luminosas exposiciones de la visión que tenía Husserl del proyecto ontológico que habría de ofrecer un fundamento seguro a ciencias que eludían el rígido marco de trabajo lógico-matemático que se suponía estaba en su base.

Matemático de profesión al inicio de su itinerario filosófico, Husserl acompañaba a Frege en la búsqueda de un sistema axiomático completo para la matemática y, luego, para el conocimiento en general. A la par de este último, le resulta a Husserl también insatisfactorio un proyecto como el de Mach, que, como hemos ya señalado, se acerca peligrosamente al psicologismo, es decir, al intento de fundamentar el conocimiento en una disciplina empírica (llámese psicología o fisiología) cuya propia fundamentación racional quedaría en el aire, incapaz de explicar por qué posee ese estatus especial de disciplina fundamentante.

Para Husserl, los cambios revolucionarios al inicio del nuevo siglo requieren una fundamentación realmente ontológica. Es decir una verdadera o por fin realizada vuelta al proyecto de la metafísica primera de Aristóteles. Entonces, nos recuerda Federico Riu en su libro que recoge sus clases magistrales de la Cátedra Ontología Contemporánea de 1963-64 de la Escuela de Filosofía de la Universidad Central de Venezuela, Husserl distingue entre una “ontología formal”, que concibe como una “teoría a priori de los objetos en cuanto tales” y las ontologías “regionales” (Riu, 1997, p. 7). La primera, la ontología general, sería una teoría de tipo trascendental kantiano, muy cercana al proyecto lógico-axiomático. Pero se distingue de este último en la medida en que busca algo diferente a axiomas: busca “esencias” de objetos formales, lógicos, geométrico-analíticos y matemáticos, no simplemente una sintaxis que sostenga argumentaciones racionales. Este es un proceder típicamente aristotélico, porque para Aristóteles, como lo evidencia el libro XII de su Metafísica, las substancias particulares son los objetos preeminentes en el universo, y no los géneros y las especies, que ofrecerían una explicación con un grado de generalidad o abstracción demasiado alto. Por lo tanto, poder definir lo que algo es requiere poder distinguir substancias empíricamente diferentes.

A esta tarea está plenamente dedicado el segundo proyecto de Husserl que Riu menciona, a saber, el de la definición de un corpus de “ciencias eidéticas” entendidas como el descubrimiento de las esencias de las ontologías regionales que serían

“como indica Husserl -escribe Riu- las ‘verdaderas esencias’: esencias con un contenido determinado, propias de objetos concretos. De acuerdo con la división general de la objetividad empírica las ‘ontologías regionales’ se dividen en dos grandes grupos: las que corresponden al dominio de la naturaleza (las del ente material y animal) y las que corresponden al dominio del espíritu” (es decir, el de la historia y otras disciplinas humanísticas (Riu, 1997, p. 7).

Se trata para Husserl de poder explicar la delimitación que hace el ser humano de dominios de objetos en un orden ontológico y no meramente científico, es decir, qué es lo que queremos decir cuando decimos que algo está vivo, o es material, o es bueno, o es justo. No se trata de proyectar de vuelta sobre el objeto la definición teórica del mismo, por ejemplo, como cuando decimos que todo lo vivo comparte la molécula ADN, una definición que surge en la biología contemporánea, sino de definir ontológicamente el dominio de objeto o el campo de estudio que le permite luego al científico decidir que la definición que acabamos de dar se aplica a un cierto tipo de objetos en el universo que llamamos entes “vivos”. La idea de Husserl es, más bien, que sin claridad respecto de las esencias de objetos ningún científico podría saber dónde buscar una definición teóricamente precisa y que necesita esa definición pre-teórica para poder ir en pos de ella.

Ser y tiempo de Heidegger es fundamental para el desarrollo y popularidad de la ontología del siglo XX y su influencia en la naciente Escuela de Filosofía de la UCV, así como en toda Latinoamérica, fue inmensa

El proyecto de Husserl tuvo un impacto enorme en Alemania, provocando el surgimiento de diversas corrientes caracterizadas por distintas comprensiones de un realismo metafísico, y destinadas a reivindicar el papel de la ontología, y por ende de la filosofía, para explicar las revoluciones teóricas que ya hemos mencionado. Casi al mismo tiempo, un discípulo de Husserl, Martin Heidegger y otro de Russell, Ludwig Wittgenstein, este último muy influenciado por Mach también, publican dos de los libros más importantes de filosofía del siglo 20: Ser y tiempo (1927) y el Tractatus Logico-Philosophicus (1921). Este último sostendrá un realismo fuerte al afirmar que una oración tendrá sentido, es decir, será semánticamente correcta para un interlocutor, si corresponde a un “estado de cosas” en el mundo, estados que se pueden mostrar con el dedo por decirlo así, y abrirá el camino a distintas corrientes positivistas que, a lo largo del siglo 20, propugnaron una fundamentación de la ciencia basada en distintas formas de interpretar el realismo ontológico. Todo esto a pesar de las protestas de Wittgenstein mismo, para quien el objetivo del Tractatus había sido poner de relieve todo lo contrario y declarar como más importante aquello que “no se puede decir” porque no corresponde a “estados de cosas” en el mundo, sino que involucra algo más crucial para el ser humano: el arte, la moral, la religión o la mística. Wittgenstein mismo, de hecho, profesaba para la época una especie de misticismo cristiano y escribió el Tractatus como valiente y arrojado oficial al mando de tropa durante la Primera Guerra Mundial (Monk, 2002).

Por su parte, el Ser y tiempo de Heidegger es fundamental para el desarrollo y popularidad de la ontología del siglo XX y su influencia en la naciente Escuela de Filosofía de la UCV, así como en toda Latinoamérica, fue inmensa. Heidegger le reprocha a Husserl que su proyecto de ontología fenomenológica atrapa al ser humano, que Heidegger llamará el “existente”, el Dasein, en la interioridad del sujeto de conocimiento, ocultando así las fuentes verdaderas de nuestro sentido de realidad, que no es el entendimiento temático por sí solo, sino nuestra relación vivaz y activa con el mundo, mundo que se abre a nosotros de distintas maneras y no meramente como objeto de nuestra curiosidad científica o cognitiva. En su búsqueda de un fundamento más profundo del conocimiento teórico en la ontología, y de una comprensión distinta del proyecto eidético de su maestro de lo que sería una ontología bien entendida, Heidegger no se pregunta, como Husserl, por un corpus de esencias o eidos, sino por aquello que, en primer lugar, constituye realmente nuestra capacidad para atribuir esencias a las cosas. Y su respuesta es tan original como inesperada: lo que hay que preguntarse es, más bien, en qué consiste la capacidad que tiene el ser humano, o el Dasein, para poder decir que algo es algo, para poder referirse al ser. Primero, parece decirnos, veamos qué es esta capacidad y luego busquemos darle nombre a las distintas esencias de objeto.

En la filosofía de Heidegger, esa capacidad es una característica óntica del ser humano mismo, por la cual a todo hombre le es posible nombrar la realidad, clasificarla, comprenderla, relacionarse con ella eficazmente. El pasado religioso de Heidegger, quien, antes de casarse con su esposa Elfriede, pensaba convertirse en sacerdote católico y esperaba acceder a una cátedra de teología, es puesto aquí en evidencia, dado que el Dasein heideggeriano es una figura adánica o mesiánica: aquel que puede nombrar todo lo real, en el sentido de poder darle un nombre a todo, y definir su ser, porque ha sido creado por Dios para ello (véase Génesis 2, 19-20). Esta capacidad humana fue destacada por la escolástica tomista y de allí pasó a la comprensión de la ontología de Heidegger.

Por lo tanto, el Dasein no es simplemente quien intuye las esencias de lo real en su cabeza, por decirlo así, sino quien está “hecho” en su ser profundo como un ente que, en tanto que tal, está preocupado por el ser de todas las cosas, incluyendo su ser como existente. El Dasein, dice Heidegger, es aquel ente a quien le incumbe particularmente la pregunta por el ser. Por esta razón el Dasein se encuentra también especialmente llamado tanto a definir continuamente quién es y qué es lo que va a hacer en cada instante (una tarea cuyo desarrollo filosófico da lugar al existencialismo francés de Jean Paul Sartre y Simone de Beauvoir), como a definir las esencias de las ontologías regionales (aquellas que formaban parte del proyecto de ciencias eidéticas de Husserl), para resolver de una vez por todas las “crisis” en las ciencias, crisis que Heidegger también define como crisis en sus fundamentos.

La publicación del Ser y Tiempo tiene un impacto enorme en la filosofía de su tiempo. Rápidamente convierte a su autor en uno de los filósofos más importantes de Alemania y Europa, por una razón sobre la cual un discípulo de Riu, Fernando Rodríguez, nos llamaba la atención siempre en sus clases de la Escuela de Filosofía: de pronto y sorpresivamente, y nada menos que en el siglo de las ciencias, la filosofía se convertía en una disciplina básica incluso más importante que la lógica y la matemática. Heidegger anuncia en su libro que intentaba ofrecer una fundamentación en la ontología para todas las ciencias de su tiempo, a fin de salvarlas de su mayor peligro, a saber, las crisis que hizo tambalear la validez de una serie de teorías científicas que se daban por seguras y completamente acabadas. Por si fuera poco, esta nueva ontología general también ofrecería una nueva visión de la persona, entendida desde un existencialismo ateo que convierte a la acción humana en el centro de un tipo de reflexión con importantes consecuencias para la acción moral y política.

Después de la publicación de su libro, la creciente fama internacional de Heidegger le permite escalar posiciones en la academia también después del ascenso de Hitler al poder. Incluso la derrota de Alemania, después de la Segunda Guerra Mundial, lo aleja sólo momentáneamente de su cátedra. Gracias a la intervención de importantes filósofos europeos y franceses, grandemente influenciados por su pensamiento y por lo que él ha hecho, sin duda alguna, para reivindicar la relevancia del quehacer de los filósofos profesionales en el siglo XX, Heidegger es restituido en su cátedra en 1951. Ernst Tugendhat, tutor de mi tesis doctoral en Berlín, y quien fuera estudiante de Heidegger en su juventud, me contó que ya incluso en 1949 los estudiantes, él incluido, hacían pequeñas manifestaciones con pancartas por el campus de la Universidad de Freiburg exigiendo la restitución inmediata en su cátedra del gran y afamado maestro de la filosofía alemana.

Una escuela alemana

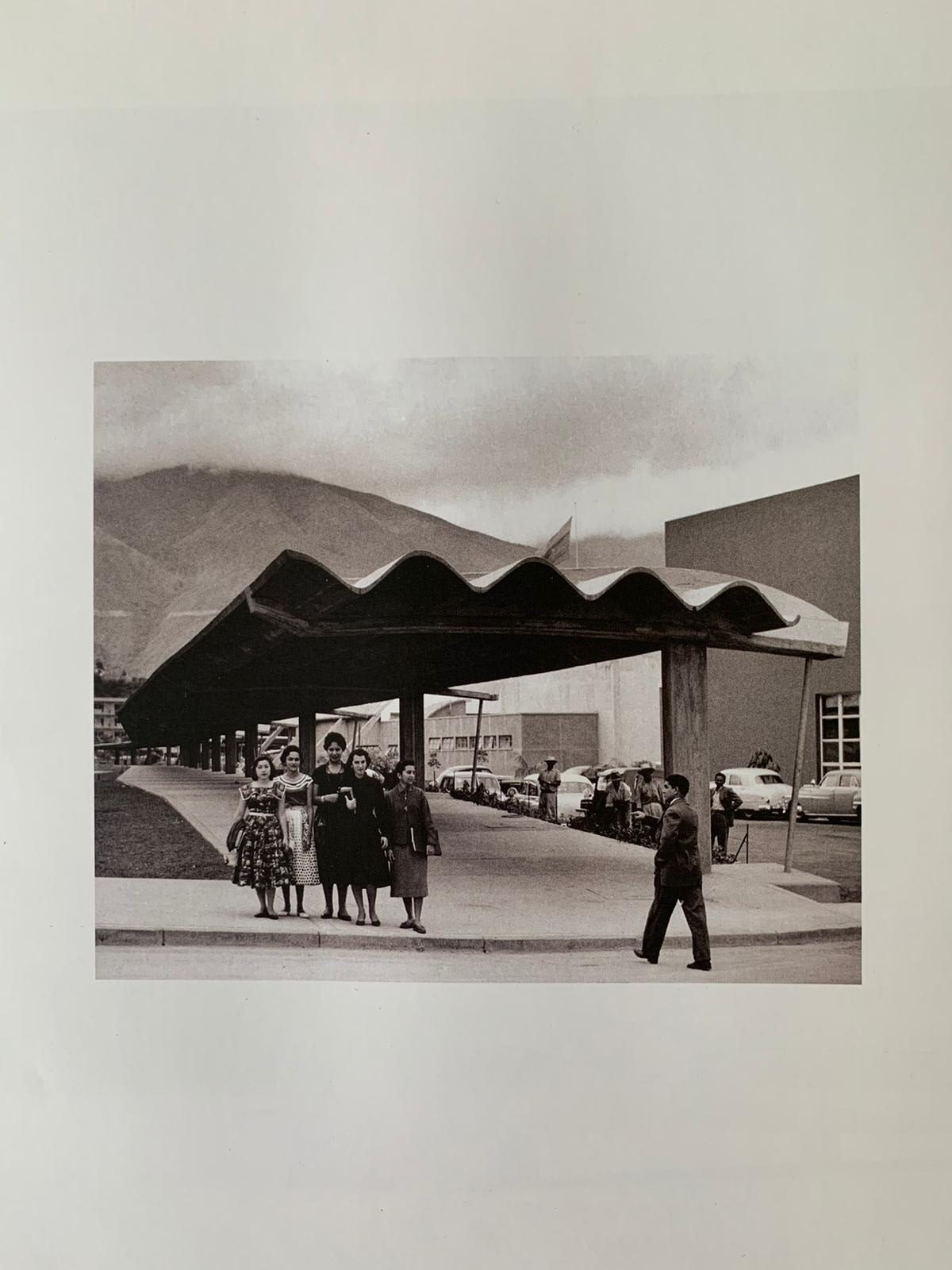

En 1945, un grupo de estudiantes de bachillerato de Caracas se reunió con Rafael Vegas, Ministro de Educación del presidente de Venezuela, Isaías Medina Angarita, para pedirle que promoviera la fundación de una Facultad de Filosofía en la Universidad Central de Venezuela. Esos estudiantes eran, hasta donde los recuerda el filósofo venezolano Alberto Rosales (nacido en 1931): Ernesto Mayz Vallenilla, José Melis Orsini, Gustavo Pérez Luciani y Gustavo Planchart.

Es interesante detenerse un poco sobre el hecho de que un grupo de jóvenes se haya acercado a un ministro de educación en funciones con una solicitud de esta naturaleza. Evidentemente, elevar una solicitud de este tipo ante una instancia gubernamental de tal envergadura sólo tiene sentido sobre el trasfondo de la nueva e inesperada relevancia de la filosofía como carrera universitaria, una relevancia que se extiende hasta Venezuela desde Europa y, en particular, como ya hemos señalado, desde Alemania.

Sin duda, cada época histórica tiene sus propios hitos de excelencia, que para sus jóvenes definen su horizonte aspiracional. En su lucha por alcanzarlo, esos jóvenes van configurando su idea de la contribución personal que pueden hacer a su entorno vital, la cual se convertirá para ellos en fuente de orgullo y autoestima, en un testigo del impacto que sus vidas han tenido o pueden llegar a tener. A mediados del siglo XX, la filosofía alemana parecía definir realmente ese hito y ese horizonte al que había que aspirar. Y no simplemente la filosofía a secas, sino la ontología y, en particular, la ontología fenomenológica, aquel proyecto cuya urgencia había comprendido Franz Brentano en 1862.

A la solicitud de aquellos jóvenes, el ministro Vegas respondió que traer los profesores y fundarla sería muy costoso, pero a cambio les ofreció que el gobierno de aquel entonces los becase para que ellos fueran a estudiar filosofía a Buenos Aires.

En julio de 1945 viajaron, pues, en barco a Argentina. No obstante, el golpe de estado en contra del Presidente Medina en octubre de ese año interrumpió la ayuda económica que recibían y tuvieron que regresarse rápidamente en avión. Dado que todos siguieron insistiendo sobre la necesidad de fundar una Facultad de Filosofía en la Universidad Central de Venezuela, Humberto García Arocha, quien era el nuevo ministro de educación de la Junta Revolucionaria de Gobierno (hasta 1946, porque Gallegos fue derrocado y ascendió al poder la dictadura militar), terminó secundándolos en sus esfuerzos.

Fue en esa época, 1946, que se iniciaron formalmente los estudios de Filosofía en la UCV. Se invitó al gran filósofo español Juan David García Bacca, un lógico y un filósofo de la ciencia, a formar parte de la plantilla de profesores. Este consolidó de manera rigurosa la estructura general de los estudios y es considerado el fundador de la Escuela de Filosofía en su forma actual. También vino a Venezuela el no menos importante pensador Eugenio Imaz, especialista en la obra de Dilthey. Más tarde Guillermo Pérez Enciso y Manuel Granell se unieron a su grupo de profesores, del cual formaba parte también ya la profesora Federica de Ritter.

Como hemos mencionado, Ernesto Mayz Vallenilla fue uno de los jóvenes impulsores de la idea de que se pudiera estudiar filosofía en Venezuela de forma seria y estructurada. En 1950, Mayz Vallenilla, junto con un compañero de estudios de origen alemán, Franz Herbert Weibezahn Messiani, viajan a Alemania, becados por el Deutscher Akademischer Austauschdienst (DAAD, Servicio de Intercambio Académico Alemán). Mayz Vallenilla viaja a Göttingen, a estudiar con Nikolai Hartmann, pero Hartmann lamentablemente fallece ese mismo año al chocar su bicicleta contra un árbol mientras la manejaba distraído (según me contó el mismo Dr. Mayz, quien agregaba, no sé si en broma, que la causa de la distracción de Hartmann había sido una bonita estudiante).

A mediados del siglo XX, la filosofía alemana parecía definir realmente ese hito y ese horizonte al que había que aspirar. Y no simplemente la filosofía a secas, sino la ontología y, en particular, la ontología fenomenológica, aquel proyecto cuya urgencia había comprendido Franz Brentano en 1862.

En 1954, otro estudiante de la Escuela viaja a Freiburg como doctorando, el ya mencionado Federico Riu, quien permanece allí dos años. Toma clases con Martin Heidegger y Eugen Fink. Como resultado de estos estudios, en su libro Ontología del siglo XX Riu analiza con incomparable rigor y claridad las ontologías de Edmund Husserl, Nikolai Hartmann, Martin Heidegger y Jean Paul Sartre, y define un programa de estudios para la Cátedra de la Escuela de Filosofía de la UCV “Ontología General”, cátedra que yo asumo en 1985 después de ganar un concurso de oposición del cual él mismo fue coordinador.

Pero quedémonos un poco todavía en 1950. A raíz de la muerte de Hartmann, Mayz Vallenilla se va a Freiburg a estudiar con Martin Heidegger, quien se había convertido en el impulsor de un proyecto de amplio espectro para la fundamentación ontológica del conocimiento, en la línea del de las ciencias eidéticas de Husserl, pero teñido por su peculiar antropología filosófica de corte existencialista. En contraste con el de Husserl, el proyecto de Heidegger es crucialmente innovador, de un modo que llama la atención inmediatamente a sus contemporáneos, porque tiene un carácter no-cognitivista, es decir, no queda atrapado por lo que Jürgen Habermas llamará luego la “filosofía de la conciencia” (Habermas, 1968), sino que insiste en la necesidad de comprender el sujeto de conocimiento como un ente que posee una comprensión pre-teorética (u óntico-ontológica) del ser. Lo hace en tanto que Dasein, o “ser-ahí” es decir, en tanto que individuo que se mueve en un mundo de maneras prácticas, activas, no meramente como un sujeto con una conciencia intencional, sino como alguien que también tiene que decidir a cada instante quién es él mismo y qué es lo que va a hacer en el momento siguiente.

Esta comprensión no reduccionista de la ontología tiene un gran impacto entre sus estudiantes. Heidegger basa su proyecto de fundamentación ontológica de las ciencias no meramente en una fenomenología de la conciencia intencional, como lo había hecho Husserl, sino en lo que él mismo denomina una “analítica existenciaria del ser-ahí (o Dasein)”, que él concibe, de un modo que no queda restringido a la conciencia, según el modelo de la analítica del entendimiento puro de Kant, tal y como este la había definido en la Crítica de la razón pura de 1781. En otras palabras: el proyecto de fundamentación del conocimiento científico en la ontología debe apoyarse ahora en una antropología filosófica, en una concepción de los modos de ser del ser humano, en tanto que ente que existe y que posee ya una comprensión pre-teórica del ser.

Las categorías esbozadas por Kant en la Crítica son redefinidas por Heidegger como un nuevo tipo de categorías: como “existenciarios”, categorías no del entendimiento, sino propias de un ser humano quien en su contacto práctico, activo, con el mundo ya posee una visión pre-ontológica de la realidad. En contraste con la idea que tenía Husserl del proyecto de ciencias eidéticas, la primera forma de ontología no es una ontología formal, una ontología del objeto en general, o trascendental, al estilo de Kant, que para la época se pensaba que podía ser un sistema lógico-axiomático como vimos arriba, sino una concepción de la persona, casi una ética en el fondo. Esto es tremendamente sugerente y revolucionario para la época. Para el Heidegger de Ser y Tiempo, esta habría de ser el paso previo para una ontología general, la cual, a su vez, daría lugar a los análisis de los distintos dominios de objeto de las ontologías regionales.

Cuando Mayz Vallenilla llega a Freiburg se encuentra con que otro estudiante venezolano ya tenía tiempo trabajando con Heidegger. La revelación, que le hace un compañero de clase nada más llegar, lo llena de asombro, dado su papel y su insistencia en la creación de un centro de estudios filosóficos moderno en Venezuela, del cual se sabía pionero. El otro estudiante venezolano resultó ser el filósofo alemán de origen judío Ernst Tugendhat, quien sería años después mi tutor de tesis doctoral, y uno de los más importantes filósofos de su generación. Nacido en 1930 y, por lo tanto, cinco años más joven que Mayz, Tugendhat y su familia habían huido de la Alemania nazi en 1939 y llegado a Venezuela como refugiados, seguramente bajo el amparo del gobierno del General Eleazar López Contreras, quien permitió generosamente la entrada a Venezuela a barcos de refugiados judíos provenientes de Europa, mientras otros países de la región, para no enemistarse con la Alemania nazi, les negaban su autorización de desembarco.

A la familia de Tugendhat la acompañaba una tía, Käte Victorius, quien había sido estudiante de Heidegger y, tal vez, también una amiga íntima. De acuerdo con lo que me contó mi maestro, por insistencia de ella, la familia enviaba cajas de comida regularmente a Heidegger y a su familia, durante la Segunda Guerra Mundial y seguro especialmente después de la guerra, cuando despojaron a Heidegger de su cátedra por sus vínculos con el nazismo y, en consecuencia, se inicia para él un período de penurias y pobreza personales. Entre los alimentos enviados siempre se encontraba el café venezolano, que consideraban de excelente calidad. De hecho, en una de sus visitas a Venezuela durante los años 80 del siglo pasado, llevé a Tugendhat en mi automóvil a lo largo de la avenida principal de Las Palmas, en Caracas, en una búsqueda infructuosa de su antigua casa, que ya no pudo reconocer, o que tal vez ya había sido demolida.

Según me contó el Dr. Mayz Vallenilla, en parte por la deuda de generosidad que Heidegger mantenía con la familia Tugendhat, el joven estudiante disfrutaba de un privilegio especial como su alumno. Tugendhat había abandonado en 1946 Venezuela para irse a estudiar a Stanford, en los EEUU, y luego en 1949 se había instalado en Freiburg, a donde acudió expresamente para estudiar con el filósofo de fama mundial que había sido profesor de su tía y a quien su familia había apoyado económicamente durante años muy difíciles. Seguramente también la vocación como filósofo de Tugendhat nace a la luz de la influencia de su tía, quien lo introduce al pensamiento filosófico de tipo heideggeriano cuando es todavía un niño. Según me contó, ya no recuerdo si el Dr. Tugendhat o el Dr. Mayz, el joven Tugendhat podía, por ejemplo, en su condición de hijo putativo del gran filósofo, apartar los puestos en primera final de las clases magistrales de Heidegger, a las que concurrían multitudes ansiosas de escucharle y en donde era muy difícil conseguir un lugar. Lo hacía con la mejor de las diligencias y buena disposición, lo que le ganó muchos amigos y aumentó su popularidad entre sus compañeros. Solía montar al Dr. Mayz, un hombre que era alto, en el manubrio de su bicicleta y conducir con él por las calles de Freiburg, mientras ambos cantaban a viva voz. Pronto el Dr. Mayz estaba muy contento de compartir la gloria de ser el primer venezolano en estudiar con Heidegger con el simpático joven. El profesor Tugendhat, por cierto, ostentó el pasaporte venezolano durante mucho tiempo, hasta que años después, ya siendo profesor en Alemania, solicitó por fin la ciudadanía alemana.

Mayz Vallenilla regresa al país en 1953 con su tesis doctoral casi lista. Inicia con ella una trayectoria de investigación muy imbuida en los temas y problemas que caracterizaron la época ontológica de la filosofía. En 1960, publica su Ontología del conocimiento. Se trata de un libro muy influenciado por el pensamiento de Heidegger en Ser y tiempo, que toma como punto de partida de un gran proyecto arquitectónico de carácter sistemático, dentro del cual Mayz Vallenilla se insertaría con el desarrollo de una ontología regional en particular, la que atañe a los fundamentos ontológicos del conocimiento.

Este tratado, publicado por la Facultad de Humanidades y Educación de la UCV en una bella y elegante edición de tapa dura en tela con sobrecubierta, consta de casi 450 páginas. En concordancia con el ambicioso proyecto de la ontología del siglo XX que, recordemos, quiere ofrecer los fundamentos definitivos de todo conocimiento teórico, erigiendo a la filosofía de hecho como una ciencia básica y condición de todas las demás, el libro de Mayz Vallenilla desarrolla, dentro del marco teórico del proyecto que había presentado Heidegger en su libro de 1927, una fundamentación ontológica del conocimiento.

Los filósofos de las generaciones más recientes, quizás contagiados por un clima de precariedad del conocimiento en general, por el así llamado “postmodernismo”, con el flujo incesante de novedades al que nos han acostumbrado los medios de comunicación y las redes sociales y que Heidegger mismo ya había denunciado y predicho con su concepto existenciario de las “habladurías”, hemos perdido un poco la convicción de que la filosofía también puede ser vista como una teoría acumulativa que avanza y se acerca cada vez más hacia la verdad. Esta convicción es muy antigua y no fue puesta en duda sino hasta bien entrado el siglo XX. Ella animaba también este tratado de Mayz Vallenilla. Sin embargo, ya en Mayz comienza poco a poco a emerger también, al mismo tiempo, la clara conciencia de la dependencia de la ontología respecto de los modos de percibir la realidad que caracterizan a la racionalidad de cada época, dando paso también a un relativismo histórico del conocimiento en general:

“Si es cierto que desde el más lejano tiempo resplandece la Verdad, a todo hombre le está concedido el privilegio de pensarla nuevamente y descubrir, mediante riguroso esfuerzo, nuevas facetas suyas. La Verdad, en cuanto tal, es en sí misma inagotable. Mas sólo pensando la Verdad puede descubrirse lo aún oculto en ella. El afán de hacerla progresar y desvelar sus nuevos rostros impone que aquel que lo desee se deje influenciar por quienes precedentemente la han pensado y han llevado al pensamiento hasta su horizonte actual” (Mayz Vallenilla, 1960, p. 3).

Así pues, aunque la Ontología aspiraba a completar una tarea que Heidegger se había propuesto pero había dejado inconclusa por estar su atención “absorbida por otras ingentes y fundamentales cuestiones ontológicas” (Ibid, p. 4), y el punto de partida de este libro no se distingue del proyecto heideggeriano que aspiraba a desarrollar una ontología fundamentante, o una analítica “existenciaria” como paso previo al desarrollo de una verdadera ontología general, Mayz Vallenilla no puede menos que constatar la circularidad implícita en la intención de fundar un recuento de la verdad sobre los modos como el ser humano (el existente, el Dasein) se relaciona con el mundo en cada época dada:

“Pero incluso, por cuanto para determinar el ‘ser’ del Conocer es necesario acudir a un análisis temporal de aquello que él mismo muestra como fenómeno, pero ya en esta misma urdimbre temporal yace implícita una determinada y previa idea del Ser, la investigación debe tener en cuenta que la pregunta formulada –‘¿por qué conocemos?’- ha de enfrentarse con un ineludible ‘círculo’. Ello responde –como habrá de verse- a la estructura circular en que se mueve y despliega todo auténtico y riguroso Preguntar ontológico” (Ibid, p. 17).

A diferencia del Heidegger de Ser y Tiempo, Mayz Vallenilla puede comprobar que la circularidad que define a la empresa ontológica desde el inicio, la conduce a una inevitable “retroreferencia ontológica” (p.16) que vuelve prácticamente indistinguible la ontología fundamental del proyecto más amplio de la ontología general.

En efecto, Heidegger había abandonado, tres décadas antes, su proyecto de amplio alcance cuando se dio cuenta de que, por la imposibilidad de distinguir una ontología general de una fundamental, la ontología general resultante nunca tendría el carácter de una ciencia teórica acabada, como, por ejemplo, la lógica formal de primer orden sí lo estaba y, por lo tanto, no podía ofrecer una alternativa viable al sistema axiomático que se había estado buscando a inicios del siglo XX para fundamentar todo el conocimiento y evitar lo que el mismo Heidegger denunciaba como un estado de perenne crisis o precariedad de las ciencias. Pero en el momento en que Mayz Vallenilla escribe, el proyecto de un sistema axiomático completo como fundamento de la ciencia ha quedado en el olvido y es posible representar la ontología de Heidegger de otra manera, más cónsona con los desarrollos de la epistemología de la época.

Mayz Vallenilla ya no ve, pues, la ontología como una disciplina que es posible formular de una vez por todas, sino como un tipo de análisis que, aun siendo ontológico, siempre estará inconcluso para cada generación de filósofos, precisamente por el carácter inagotable de la Verdad, en mayúsculas. A medida que avanza el siglo, y aumentan el caudal y la publicidad de los conocimientos científicos, se vuelve cada vez más claro que la tarea de fundamentación del conocimiento siempre quedará inacabada, siempre sufrirá una cierta circularidad.

Que Heidegger haya tenido dificultades para ver esto (mientras que Mayz Vallenilla ya lo entendía bien a mediados del siglo XX) y haya abandonado básicamente el plan inicial que había prefigurado en su Ser y tiempo, probablemente tiene que ver con el hecho de que la noticia de la imposibilidad de una fundamentación axiomática del conocimiento no se produce sino hasta 1931, con la publicación del artículo del matemático Kurt Gödel “Über formal unentscheidbare Sätze der Principia Mathematica und verwandter Systeme, I” (“Sobre proposiciones formalmente indecidibles del Principia Mathematica y sistemas relacionados”). Este artículo desarrolla su famoso “teorema de la incompletitud”, que afirma que cualquier sistema axiomático, si es completo será inconsistente y si es consistente será incompleto (Cfr. Da Silva, 2014, para un buen análisis del descubrimiento de Gödel). Gödel lo demuestra al señalar que, en todo sistema axiomático, al menos un axioma o proposición no puede ser demostrada por el sistema axiomático en cuestión.

Este resultado era contrario al proyecto esbozado por Hilbert en 1900, dado que la idea original era fundamentar la teoría en un sistema de axiomas auto-evidentes para todos los sujetos de conocimiento. Si resulta que un sistema de axiomas comporta uno que no es auto-evidente, sino que requiere un compromiso previo con un sistema axiomático distinto, la teoría que se levanta sobre él no puede presumir de ser verdadera en el sentido definido por la filosofía de la ciencia de inicios del siglo XX, que es un sentido fuerte u ontológico.

Otra manera de ver lo extraño que es este resultado es imaginar que ponemos en un mismo “saco” todas las geometrías no euclidianas sobre las que Hilbert mismo estaba trabajando. Seguramente tendremos un arqueo exhaustivo o completo de todos los sistemas axiomáticos que sostienen la validez de tales geometrías exóticas, muchas de las cuales son constructos elegantes y coherentes sin aplicación práctica, pero el resultado de ese conglomerado ¿sería un solo sistema auto-consistente capaz de dar cuenta de la geometría del universo de modo coherente, en el sentido de que tendríamos una sola geometría verdadera para describir la realidad? La respuesta es que no.

Este resultado es devastador para el proyecto esbozado por Hilbert, pero también para el proyecto de una ontología totalizadora entendida como ciencia básica, aunque los verdaderos alcances de la demostración de Gödel fueron percolando poco a poco en la conciencia de los filósofos y científicos de la segunda mitad de siglo. Ya para mediados de siglo, cuando Mayz Vallenilla publica su trabajo, hay una claridad sobre los límites de todo pensamiento ontológico que no existía tan sólo unas décadas antes. Finalmente, esa nueva conciencia es la que se asoma cuando el Dr. Mayz, en su libro de 1990, Fundamentos de la meta-técnica, escribe lo siguiente:

“En tanto que actividad humana, el quehacer técnico es eminentemente histórico… y, como tal, se halla expuesto a sufrir o a provocar las transformaciones que el propio hombre promueve mediante las obras de su libertad. Ello determina que su sentido y sus metas se encuentren en íntima relación con los cambios experimentados por la epistemología y la ontología de su época” (Mayz Vallenilla, Fundamentos de la meta-técnica, 1990, p. 11).

El filósofo venezolano nacido en 1931, Alberto Rosales, quien ingresa como estudiante de nuestra Escuela de Filosofía en el año 1950 y había sido alumno de Mayz en el Liceo Andrés Bello de Caracas, tiene la oportunidad de viajar entre 1953 y 1954 a Alemania como estudiante, incluso ya antes de obtener su licenciatura en Filosofía por la UCV. Regresa a ese país después de su graduación, en 1957, para escribir su disertación doctoral durante los años 1957-60 y 1962-1967. Rosales posee una extensa obra escrita y publicada en alemán. Su tesis doctoral, titulada Transzendenz und Differenz, abre una amplia trayectoria de investigación caracterizada por intereses filosóficos que giran en la órbita del proyecto ontológico y fenomenológico alemanes, en particular alrededor también de la obra del gran maestro alemán Martin Heidegger. No obstante, al igual que Mayz Vanellina, su interpretación de las tareas de la filosofía está informada por el paulatino declive del programa de fundamentación del conocimiento en general al que aspiraba la ontología del siglo XX, cuyas razones ya hemos esbozado arriba, y, por lo tanto, propone una definición del quehacer de los filósofos distinta a las aspiraciones emblemáticas de Husserl o Heidegger.

La filosofía que abandona su aspiraciones de ofrecer una fundamentación firme o definitiva del conocimiento se verá necesariamente confrontada con el problema de averiguar en dónde reside, entonces, su unidad como proyecto teórico autónomo, es decir, su capacidad de ofrecer respuestas con carácter acumulativo a sus problemas, del mismo modo en que pudiéramos decir, por ejemplo, que la mecánica clásica de Newton y la teoría de la relatividad general de Einstein forman parte ambas legítimamente de la física teórica vista como un todo.

Rosales encara esta pregunta en un ensayo titulado “El problema de la unidad de la filosofía” (Rosales, 2011). Allí se pregunta justamente si podemos decir todavía que la filosofía posee la unidad de una ciencia rigurosa, en el sentido de que todas ellas contribuyan de modo parcial a la Verdad, con mayúsculas. Una de las dificultades que Rosales plantea expresamente es la de definir el verdadero objetivo de la filosofía:

“Lo que se llama “la ciencia” en singular es en verdad una pluralidad de ciencias de hechos, que se diferencian unas de otras, en tanto ellas se reparten la totalidad de lo que es, dividiéndola en múltiples provincias. Por el contrario, las filosofías versan sobre ese todo, aun cuando algunas de ellas nieguen expresamente esa posibilidad” (Ibid., p. 69, énfasis del autor).

Lo que tenemos ahora son filosofías que versan sobre el todo. La filosofía estaría interesada en totalidades “de diversa amplitud” (Ibid., p. 70) y sus conceptos propios son llamados por él conceptos omniconcernientes, en la medida en que abarcan totalidades de entes, como los tradicionales conceptos universales, o abarcan entes singulares de envergadura metafísica, como Dios o mundo. Pero estos conceptos “omniconcernientes” no tendrían una realidad ontológica propia.

“Si los omniconcernientes yacen en la cosas mismas o son meros pensamientos (conceptos) de los filósofos, o sólo palabras y signos, o no corresponden a ninguna de esas posibilidades, queda aquí una cuestión abierta, que debe ser respondida por cada proyecto filosófico que merezca ese nombre” (Ibidem).

Esto significa que el filósofo no está obligado a un compromiso realista con las definiciones que ofrece a los conceptos omniconcernientes de los que se ocupa, y tiene libertad para considerarlos como quiera. La tarea específicamente filosófica para Rosales es ofrecer definiciones para los conceptos omniconcernientes, dejando abierta la cuestión de su existencia metafísica u ontológica. Se trata de una definición formal de la estructura del pensamiento filosófico, dejando abierta la pregunta por la validez del contenido de sus definiciones (Ibid., p. 72).

El camino del filosofar no es pues, para Rosales,

“…ni un mero interpretar algo ya comprendido, ni la intuición intelectual de la esencia de las cosas, ni la elaboración de un concepto general empírico a través de la inducción, ni la reflexión de la subjetividad sobre sí misma, sino un inventar, que se guía por posibilidades bosquejadas, afronta las singularidades dadas y toma en cuenta, positiva o negativamente, las respuestas del pasado”(Ibid., p. 78, énfasis del autor).

Con ello, ya le hemos dado la vuelta al círculo que había encontrado Mayz. Pero esta dependencia de las respuestas de la filosofía a la situación finita o limitada históricamente del filósofo, que necesariamente rinde como resultado proyectos y perspectivas parciales, no necesita desembocar en un relativismo del conocimiento filosófico, dado que cada perspectiva filosófica ilumina sin duda un aspecto limitado o restringido de aquello definido por los conceptos omniconcernientes. Sin embargo, en cuanto al proyecto de la filosofía de abarcar la Verdad, con mayúsculas, a ninguna perspectiva filosófica finita le es posible alcanzar el todo al que aspira.

El declive de la ontología y Kant revisitado

En los años 80, cuando yo todavía estudiaba mi pregrado, vino a Venezuela a visitar a su familia, como lo hizo todos los años hasta la muerte de su padre, un joven filósofo venezolano que ya para aquel momento disfrutaba de una posición muy destacada como profesor e investigador de la Ludwig Maximilians Universität de Munich, cuyo Instituto de Filosofía, Lógica y Filosofía de la Ciencia llegó a dirigir hasta su jubilación en el 2012.

Discípulo de destacados filósofos de la ciencia alemanes e ingleses, en una de sus conferencias que tuve la oportunidad de escuchar, Carlos Ulises Moulines expuso las diferencias entre las preguntas de la filosofía centrada, por un lado, en la ontología y la filosofía de la ciencia o epistemología, por el otro. El tránsito de la una a la otra había marcado el itinerario filosófico de casi todo el siglo XX, un siglo caracterizado por la eclosión de importantes desarrollos filosóficos y científicos en todos los órdenes. Esta conferencia resultó luminosa para mí, porque alejaba a la epistemología de la ciencia contemporánea del ambicioso proyecto de la ontología del siglo XX, sin desmerecerlo, pero dejando claro de una vez por todas lo que parecía realmente posible alcanzar para el sujeto de conocimiento: no las fuentes ontológicas últimas del conocimiento de la realidad, sino modelos de validez variable para las teorías científicas.

Ese tránsito implicaba que la prueba de Gödel, de 1931, poco a poco había ganado terreno en la comprensión de los fundamentos axiomáticos del conocimiento. Probablemente también, como hemos visto, la misma explosión de diversas aproximaciones a la ciencia, y diversas maneras de entender el saber científico, volvieron a la ontología, entendida como una visión rígida y unívoca de la realidad, una aspiración obsoleta, al menos bajo esa forma.

En nuestra Escuela de Filosofía, gracias a la influencia de Ezra Heymann (1928-2014), un discípulo de Hans Georg Gadamer que se integró como profesor a nuestra universidad en 1977, y que, como filósofo educado en la órbita de la filosofía alemana, comprendía muy bien los alcances y las aspiraciones de la misma, el declive de la ontología del siglo XX pudo reinterpretarse como el triunfo de Kant y su visión de la razón humana, tanto en su uso teórico como en su uso práctico, temas a cuyo desarrollo y reflexión este profesor, quien fuera mi tutor de la tesis de Licenciatura y otro de mis maestros, dedicó buena parte de su fecunda actividad docente e investigativa.

En este sentido, la influencia entre sus discípulos de la visión que el profesor Heymann tenía del esquematismo kantiano nos permitió contar con una concepción del conocimiento más cónsona con enfoques más actuales de la epistemología y las ciencias. Según esta visión, el abandono por parte de Kant de las aspiraciones de la metafísica segunda para poder definir de manera dogmática objetos de los cuales no tenemos experiencia alguna, tal y como él formula esta imposibilidad en la Crítica de la razón pura, da paso a una perspectiva de la razón teórica conforme a la analogía de la Revolución Copernicana, en donde el objeto se adapta a nuestras capacidades formales para aprehenderlo (con las formas puras de la intuición y los conceptos puros del entendimiento) sin por ello pretender agotarlo en su materialidad total como objeto dado en la experiencia sensible.

Una visión de este tipo habría sido imposible en la metafísica de Aristóteles, para quien el objeto, como substancia particular, comporta, por decirlo así, aquello que lo define como siendo algo. Para Kant, por el contrario, el objeto es lo que es si puedo decir algo de él a priori, aunque sólo como objeto de una experiencia general o posible, no como una substancia metafísica particular de algún tipo. Esta comprensión del conocimiento, que en definitiva es la que caracteriza a la mecánica clásica y a la física teórica moderna, resultó enormemente resiliente a los desarrollos de la ciencia del siglo 20, dado que se adecúa a una concepción de la ciencia entendida como un modelo que se adapta a realidades cuya ontología nunca puede darse por completamente conocida.

Tal vez el artículo de Heymann publicado en 1989 en la Revista Episteme, “El Kant de Federico Riu y el problema de la consistencia de la segunda edición de la Crítica de la razón pura”, es uno de los que mejor revela la importancia de una adecuada comprensión de la filosofía teórica kantiana para renovar el impulso fundamentador de la filosofía de la ciencia en una dirección más razonable y más acorde con los desarrollos científicos que se produjeron durante el siglo pasado, dejando con ello atrás un poco las aspiraciones de la ontología fenomenológica.

El ensayo de Heymann responde en forma polémica a un artículo publicado por Federico Riu en la misma revista en el año 1982, que se titulaba “El mundo del espejo. Crítica y metafísica de Kant”. Aquí Federico Riu, como tal vez no podía ser de otro modo, le reprocha a Kant la “pérdida” del objeto en tanto que ente, para presentarlo solamente como objeto producido por un esquematismo del entendimiento racional. De acuerdo con Riu (cita Heymann): los objetos

“sólo son y pueden ser fenómenos en tanto están representados por dichos conceptos. La idea de referencia como producción incluye esta precisión fundamental” (Heymann, 1999, p. 79).

De hecho, Kant mismo, hasta las correcciones y agregados que introdujo en la segunda edición de la CRP, parece apoyar esta visión en la que el objeto de la experiencia no es otra cosa que la unidad sintética de diversas intuiciones. En definitiva, una suerte de creación del sujeto de conocimiento que prescinde de la referencia a lo que el objeto sea realmente. Riu, el ontólogo, no puede sino lamentar que “en Kant el mundo de las cosas se transforma en un mundo de representaciones, en un dominio de la conciencia” (Heymann, 1999, p. 80). De acuerdo con la lectura que Riu presenta aquí, Kant

“se ve obligado –escribe Riu y cita Heymann- a introducir la noción de cosa en sí, que no sólo es un recurso metafísico de la peor especie, sino además un recurso que vuelve ininteligible el mundo de la experiencia” (Ibídem).

El artículo de Heymann, que atestigua la necesidad que tiene Riu de defender la ontología contra la idea de reducirla meramente a una representación de la conciencia, se aboca a demostrar que en Kant, en realidad, sí hay una ontología. De acuerdo con Heymann, esta puede ponerse de relieve por los agregados a la segunda edición de la Crítica de la razón pura que despejan la lectura pseudo-idealista de la filosofía kantiana. Escribe Heymann, refiriéndose a estos agregados:

“Ahora se dice que nuestra forma de intuición se llama sensible porque no es originaria, esto es, no da por sí sola la existencia del objeto de la intuición (lo que corresponde, por lo que entendemos, sólo al ser primordial) sino que depende de la existencia del objeto, por lo tanto del hecho de que la facultad de representación del sujeto queda afectada por el mismo (B72)” (Heymann, 1999, p. 82).

De hecho, para acabar con todo posible equívoco al respecto, insiste Heymann, Kant introdujo, en la segunda edición, un nuevo capítulo titulado “Refutación del idealismo”:

“La tesis será: ‘la mera conciencia de mi propia existencia, que es empíricamente determinada, demuestra la existencia en el espacio de objetos fuera de mi’ (B275). Estos objetos no pueden ser una intuición en mí, porque ‘las representaciones precisan algo permanente, distinguido de ellas, en relación con lo cual puede ser determinado el cambio de ellas, esto es mi existencia en el tiempo en el cual ellas cambian’ (B XXXIX)” (Ibídem).

Por otro lado, sostiene Heymann, no somos libres para inventar cualquier regla de aprehensión del objeto que queramos. Kant pensaba que el objeto impone sus reglas necesarias de aprehensión, determinando también nuestra representación del objeto como fenómeno:

“A las condiciones de la aprehensión en general (que involucran condiciones de reproducción y de reconocimiento), se agrega, pues, una condición que permite distinguir, de todas las aprehensiones realizadas de acuerdo con una regla arbitraria (aunque coherente), aquella aprehensión de una secuencia que sólo la experiencia debe poder enseñarnos. Esta condición es la condición causal. Entendemos entonces que si debe haber experiencia como instrucción por parte de la naturaleza, entonces es necesario el principio causal, de acuerdo con el cual el orden temporal de la existencia es irreversible y restringido con respecto a los órdenes posibles de aprehensión” (Heymann, 1999, p. 83).

La realidad, pues, impone sobre nuestro entendimiento sus condiciones causales (¡basadas “en el orden temporal de la existencia”!). La referencia al objeto por parte de la conciencia no es sino un dar cuenta de la unidad de las aprehensiones de la conciencia, que siempre sigue siendo, para usar el lenguaje de la ontología fenomenológica del siglo XX, conciencia intencional de un objeto real causalmente eficaz. No es verdad que, en la interpretación de Kant sobre la que insiste Heymann, el objeto no sea sino un conjunto de representaciones en nuestra conciencia. Al revés, la conciencia del objeto es posible porque es causada por un objeto diferente de ella misma. De esta manera, Heymann nos recuerda que Kant, el filósofo más compatible con los desarrollos científicos del siglo XX, sigue siendo también el impulsor de una ontología de tipo trascendental, después de todo.

Como me comentaba mi colega y también discípulo del profesor Heymann, Argenis Pareles, quien me llamó la atención sobre la importancia de este artículo, su comprensión particular del realismo kantiano expresa de manera señalada la visión que siempre tuvo nuestro maestro de que es posible armonizar una ontología con los desarrollos de la ciencia que caracterizaron el siglo XX.

No obstante, agregaría yo como corolario a esta discusión, a mi me parece indudable que Kant reintroduce el objeto como el objeto incuestionablemente real de la indagación científica a costa de presentarlo como si fuera un planeta algo lejano. En mi opinión, una cierta nebulosa opacidad parece ocultar al objeto bajo el velo determinante de la razón humana y me pregunto si Federico Riu, el estudioso de la ontología, no echaría de menos con toda razón en su crítica a Kant la pérdida del objeto como un ente vivaz, rico en connotaciones incluso poéticas, fuente de resonancias en el espectador que se esfuerza por aprehender qué sea la realidad, en el fondo y verdaderamente. Es indudable que la pregunta de la metafísica, “por qué hay ente en vez de nada”, no puede agotarse en el objeto que se deja acotar de modos precisos por una razón científica generalizable.

Sin embargo, la reivindicación que Heymann hace de Kant evoca las lecturas de Kant que permitieron también mantener vivas en Alemania las tradiciones de fundamentación del conocimiento científico que fueron importantes en las primeras décadas del siglo 20. Esa sintonía con los intereses, las perplejidades y las luchas de los filósofos alemanes estuvo presente también para nuestra generación gracias al rigor y acuciosidad como filósofo e investigador del profesor Ezra Heymann. Cuando, a finales del siglo XX, descolló como figura estelar que recogía estas tradiciones de la filosofía el alemán Jürgen Habermas, a quien se le atribuye una visión kantiana de la razón capaz de tender un puente eficaz entre la ontología del siglo XX de raíz alemana y la filosofía analítica de raíz anglosajona, ya nosotros en nuestra Escuela de Filosofía de la Universidad Central de Venezuela estábamos en plena capacidad de comprender sus verdaderos alcances e importancia.

©Trópico Absoluto

Referencias

Da Silva, R. (2014). Los teoremas de incompletitud de Gödel, teoría de conjuntos y el programa de David Hilbert. Episteme NS , 34 (1), 19-40.

Einstein, A. (1984). Sobre la teoría de la relatividad especial y general. Madrid: Alianza .

Fellmann, F. (1984). Fenomenología y expresionismo. Barcelona: Alfa.

Feser, E. (2017). Five Proof of the Existence of God. San Francisco: Ignatius Press.

Habermas, J. (1968). Erkenntnis und Interesse. Suhrkamp Verlag.

Heymann, E. (1999). Decantaciones kantianas. Comisión de Estudios de Postgrado UCV.

Lestienne, R. (1995). The Children of Time. Chicago: University of Illinois Press.

Mayz Vallenilla, E. (1990). Fundamentos de la meta-técnica. Caracas: Monte Ávila, IDEA.

Mayz Vallenilla, E. (1960). Ontología del conocimiento. Caracas: FHYE, Universidad Central de Venezuela.

Monk, R. (2002). Ludwig Wittgenstein. Barcelona: Anagrama.

Mosterín, J. (2000). Conceptos y teorías en la ciencia. Madrid: Alianza .

Moulines, C. U. (2011). El desarrollo moderno de la filosofía de la ciencia. México: UNAM, Instituto de Investigaciones Filosóficas.

Riu, F. (1997). Obras completas (Vol. 1). (F. F. Rodríguez, Ed.) Caracas: Monte Ávila Latinoamericana.

Rosales, A. (2011). El problema de la unidad de la filosofía. Filosofía (22).

Scott, E. (2020). Herman Cohen. Obtenido de Stanford Encyclopedia of Philosophy: <https://plato.stanford.edu/archives/win2020/entries/cohen/>.

Luz Marina Barreto (Caracas, 1960) es profesora titular de la Escuela de Filosofía de la Universidad Central de Venezuela. Licenciada en Filosofía por la UCV, posee una maestría en Ciencias de la Computación (UCV), y un doctorado en Filosofía por la Universidad Libre de Berlín. Fue Directora del Instituto de Filología Andrés Bello de la UCV y directora del doctorado y postgrado de filosofía de la Facultad de Humanidades y Educación. Ha publicado artículos sobre ética, teoría de la racionalidad y filosofía política. Entre sus últimas publicaciones se encuentran: “Una exploración de la semántica del concepto de derechos en Twitter”, “Sobre la universalidad y relevancia del conocimiento”, “Consenso racional y democracia deliberativa en las sociedades complejas” y “Marianne Kohn Beker, lectora de Levinas”. Actualmente trabaja sobre formación de consensos, racionalidad e información en sociedades complejas.

0 Comentarios